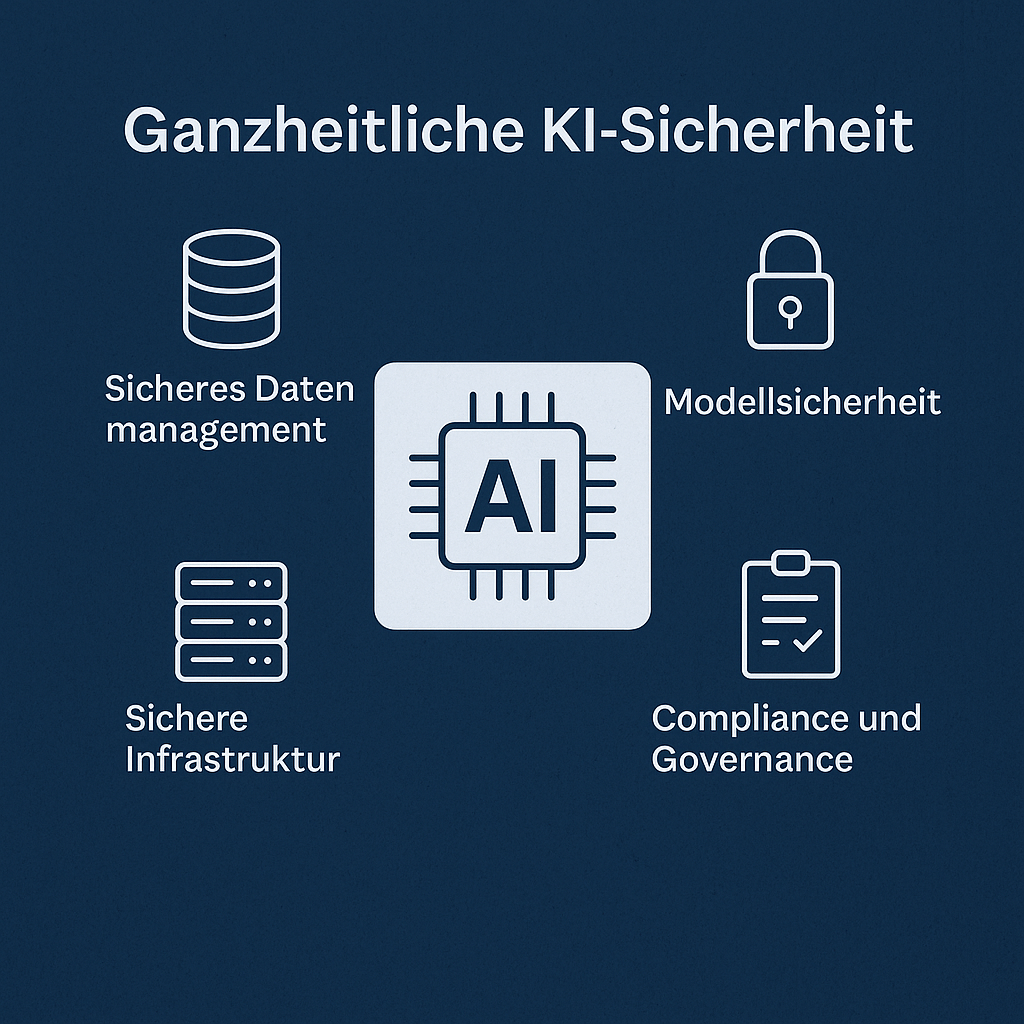

Ganzheitliche KI-Sicherheit

Ganzheitliche AI Security Lösungen: Schutz in Zeiten intelligenter Systeme

Künstliche Intelligenz (KI) ist längst kein Zukunftsthema mehr – sie durchdringt zunehmend geschäftskritische Prozesse in nahezu allen Branchen. Mit den wachsenden Möglichkeiten steigen jedoch auch die Risiken. Während klassische IT-Sicherheitsmaßnahmen weiterhin wichtig sind, greift deren Schutzmechanismus zu kurz, wenn es um KI-gestützte Systeme geht. Was es braucht, ist eine ganzheitliche AI Security Strategie, die technische, organisatorische und ethische Aspekte integriert.

Was bedeutet ganzheitliche AI Security?

Der Begriff „ganzheitlich“ steht für einen umfassenden Ansatz, der über rein technische Maßnahmen hinausgeht. Bei AI Security geht es nicht nur darum, die KI selbst vor Angriffen zu schützen, sondern auch die durch KI getroffenen Entscheidungen, Datenquellen, Modelle, Infrastrukturen und sogar regulatorische sowie ethische Anforderungen zu sichern.

Ganzheitliche AI Security Lösungen beinhalten unter anderem:

-

Schutz von Trainingsdaten

-

Absicherung der Modelle vor Manipulation (z. B. durch adversarial attacks)

-

Sicherstellung der Erklärbarkeit und Fairness von Entscheidungen

-

Schutz der Infrastruktur, in der KI-Modelle betrieben werden

-

Überwachung und Logging im Produktivbetrieb

-

Einhaltung gesetzlicher Rahmenbedingungen (z. B. EU AI Act)

Warum klassische IT-Security für KI nicht ausreicht

In klassischen IT-Umgebungen stehen Firewalls, Anti-Viren-Programme und Zugriffsmanagement im Fokus. KI-Systeme jedoch bergen andere Risiken:

-

Datenabhängigkeit: KI-Modelle lernen aus Daten – fehlerhafte, manipulierte oder unausgewogene Daten führen zu fehlerhaften oder gefährlichen Entscheidungen.

-

Black Box Charakter: Viele KI-Modelle sind schwer verständlich. Das macht es Angreifern leichter, Schwachstellen zu verstecken.

-

Dynamisches Verhalten: Modelle entwickeln sich durch Retraining weiter, was klassische Sicherheitssiegel obsolet macht.

-

Neue Angriffsszenarien: Adversarial Attacks, Model Inversion oder Data Poisoning sind spezifisch für KI.

Die 7 Schlüsselkomponenten einer ganzheitlichen AI Security Lösung

1. Sicheres Datenmanagement

Daten sind das Fundament jedes KI-Systems. Bereits hier beginnt die Security:

-

Herkunftssicherung: Daten sollten aus vertrauenswürdigen Quellen stammen.

-

Anonymisierung und Pseudonymisierung schützen personenbezogene Daten.

-

Data Lineage Tracking sorgt für Nachvollziehbarkeit.

-

Kontinuierliche Validierung verhindert Drift oder fehlerhafte Datenintegration.

2. Modellabsicherung

Modelle müssen gegen Manipulation und Ausnutzung geschützt werden.

-

Robustheitstests prüfen, wie widerstandsfähig ein Modell gegen gezielte Störungen ist.

-

Adversarial Training kann gezielt Schwächen ausmerzen.

-

Model Watermarking sichert geistiges Eigentum und erkennt fremde Nutzung.

-

Zugriffskontrollen auf Modelle verhindern unautorisierte Nutzung.

3. Explainability & Fairness

Eine „sichere“ KI muss auch erklärbar und gerecht sein:

-

Explainable AI (XAI) sorgt dafür, dass Entscheidungen nachvollziehbar sind – etwa durch LIME, SHAP oder Counterfactuals.

-

Bias Detection Frameworks helfen, Diskriminierung in Modellen zu identifizieren und zu beheben.

-

Audits durch Dritte schaffen zusätzliches Vertrauen.

4. Sichere Infrastruktur

KI-Anwendungen laufen in komplexen Infrastrukturen, die Angriffsfläche bieten:

-

Container-Security (z. B. für Kubernetes-basierte Systeme)

-

Zero Trust Architektur

-

Ende-zu-Ende Verschlüsselung

-

Monitoring & Alerting mit KI zur Erkennung anomaler Zugriffe

5. Operational Security (AI Ops)

Sicherheitsmaßnahmen dürfen nicht mit dem Deployment enden:

-

MLOps & AI Security Monitoring sorgen für kontinuierliche Überwachung.

-

Modell-Drift-Erkennung prüft Veränderungen im Datenverhalten.

-

Incident Response Playbooks für KI-bezogene Vorfälle

-

Automatisierte Model-Rollbacks bei kritischen Abweichungen

6. Governance & Compliance

Gesetze wie der EU AI Act machen AI Security auch zur Pflicht:

-

Dokumentationspflichten: z. B. Datenherkunft, Modellarchitektur, Testverfahren

-

Risikoanalysen: für Hochrisiko-Anwendungen vorgeschrieben

-

Regulatorische Sandboxes können beim sicheren Test helfen

-

Ethik-Boards & Kontrollgremien prüfen kritische Entscheidungen

7. Security by Design

Schon beim Entwurf von KI-Systemen sollte Sicherheit mitgedacht werden:

-

Threat Modeling auf KI-Ebene

-

Red Teaming für AI: Penetrationstests auf Modelle

-

Sicherheitsreviews in DevSecOps-Prozessen

-

Privacy-preserving AI Technologien: z. B. Federated Learning, Homomorphic Encryption

Schritte zur Umsetzung einer ganzheitlichen AI Security Strategie

1. Risikoanalyse & Klassifikation

-

Welche Systeme nutzen KI?

-

Welche Risiken bestehen?

-

Gibt es regulatorische Einstufungen (z. B. Hochrisiko nach EU AI Act)?

2. Architekturreview & Designplanung

-

Einführung von Security by Design-Prinzipien

-

Einbindung von Data Scientists, DevOps und Security Teams

3. Aufbau eines interdisziplinären AI Security Teams

-

IT-Security-Experten

-

Data Engineers

-

Juristen/Compliance

-

Ethikbeauftragte

4. Auswahl geeigneter Tools und Frameworks

-

MLFlow, TensorFlow Privacy, IBM AI Explainability 360, Microsoft Responsible AI Toolbox etc.

5. Kontinuierliche Schulung

-

Mitarbeiter in Datenschutz, Sicherheit und AI Ethik unterweisen

-

Red Team/Blue Team Trainings für KI-bezogene Vorfälle

6. Operationalisierung

-

Aufbau eines AI Security Monitoring Dashboards

-

Einführung regelmäßiger Audits

-

Incident Response Playbooks erstellen und testen

Was Unternehmen beachten sollten

-

KI ist kein Plug-and-Play – Sicherheitsaspekte müssen von Anfang an berücksichtigt werden.

-

Modellverhalten kann sich ändern, z. B. durch neue Daten oder Umgebungen.

-

Menschliche Aufsicht bleibt wichtig – besonders bei sensiblen Entscheidungen.

-

Open-Source-Komponenten prüfen, da viele Angriffe über unsichere Libraries erfolgen.

-

KI und IT-Security-Teams müssen enger zusammenarbeiten.

Fazit: Sicherheit als Erfolgsfaktor für vertrauenswürdige KI

KI wird zum Treiber der digitalen Transformation – doch sie bringt neue Bedrohungen mit sich, auf die klassische IT-Security nicht vorbereitet ist. Eine ganzheitliche AI Security Lösung betrachtet die gesamte Lebensdauer eines KI-Systems: von der Datenerfassung über das Training bis hin zum Betrieb. Wer KI sicher gestalten möchte, muss neue Methoden, Tools und Denkweisen integrieren – und den Menschen im Zentrum behalten.